آیا مدلهای یادگیری ماشینی می توانند خود را تفسیر کنند؟

زمانی که یک پزشک به شما توصیه می کند که باید عمل جراحی را انجام دهید سعی می کنید دلیل این تصمیم و توصیه او را جویا شویم.

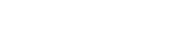

او باید ما را توجیه کند که چه عواملی باعث شده است این تصمیم را بگیرد و ما احتمالا باید قانع شویم. سیستمهای هوش مصنوعی در حال رشد بسیار سریعی هستند و در بخشهای زیادی از زندگی بشر اقدام به تصمیم سازی و حتی تصمیم گیری می کنند. سیستم های هوشمند قضاوت در دادگاه ها، پزشکان هوشمند ماشینی، سیستمهای ساده تر پردازش تصویر و تشخیص تخلف همگی از مثالهایی است که ما به عنوان بشر و انسانی که دارای اختیار است با آنها مواجه هستیم و ممکن است این سوال را با خود مطرح کنیم که ایا قضاوتی که یک سیستم هوشمند محاکم قضایی می دهد باید بدون تفسیر اجرا شود. ایا وقتی سیستم هوشمند طراحی شده برای تشخیص تقلب در بانک با دقت 92 درصد یک تراکنش یک مشتری را تقلب تشخیص می دهد، واحد مبارزه با پولشویی باید بدون تحلیل و تفسیر این نظریه که دارای دقت بالایی هم هست اقدام کند. این موضوع یک انتخاب بین معیار دقت (Accuracy) و تفسیرپذیری (Explainability) مدلهای یادگیری ماشینی است. نظریه ای وجود دارد که می گوید هر چه دقت مدل مربوطه بالاتر باشد تفسیر پذیری آن کمتر می شود. البته این رابطه بستگی زیادی به مدل استفاده شده دارد، اینکه آیا از شبکه عصبی استفاده شود یا درخت تصمیم می تواند در نسبت این رابطه تاثر گذار باشد. باید دانست که آینده هوش مصنوعی بستگی به این دارد که مدلهای یادگیری ماشینی بتوانند دلایل نتایج خود را تفسیر کنند. این مدل باید علاوه بر اینکه بتواند یک مشتری بالقوه برای ترک بانک را شناسایی و درصد دقت این پیش بینی را اعلام کند، باید بتواند تفسیری بر این تصمیم ارائه نماید. موضوع تفسیر پذیری هوش مصنوعی از جمله مباحثی است که آینده استفاده از آن را تعیین می کند، ما چه میزان به این موضوع توجه کرده ایم.

دکتر امین نظارات